Nvidia Perkenalkan Chip AI Vera Rubin, Klaim 5 Kali Lebih Bertenaga dari Generasi Sebelumnya

Nvidia terus berinovasi dalam pengembangan chip untuk AI dengan meluncurkan Vera Rubin, microchip terbaru yang diklain 5 kali lebih cepat.

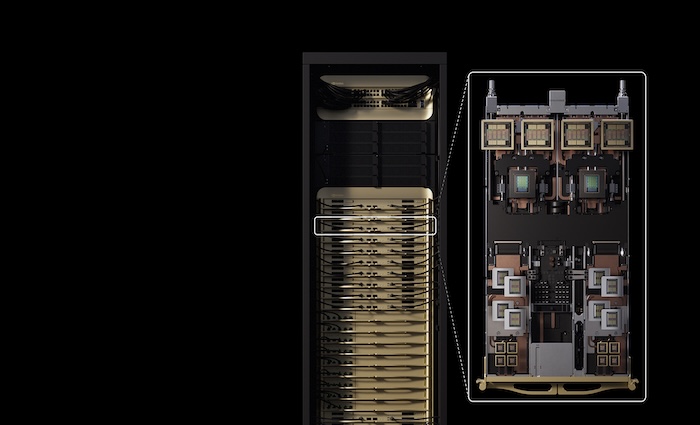

Nvidia Vera Rubin. dok. Nvidia

Nvidia Vera Rubin. dok. Nvidia

Nvidia mengumumkan chip kecerdasan buatan (AI) generasi terbaru bernama Vera Rubin. Chip ini diklaim mampu menghadirkan performa hingga lima kali lipat lebih tinggi dibandingkan chip generasi sebelumnya.

CEO Nvidia Jensen Huang mengatakan chip tersebut telah memasuki tahap “produksi penuh” dan dijadwalkan meluncur pada akhir 2026.

Pengumuman ini disampaikan dalam ajang Consumer Electronics Show (CES) 2026 di Las Vegas, Amerika Serikat.

“Inilah mengapa kami mampu menghadirkan peningkatan kinerja yang sangat besar, meskipun kami hanya memiliki 1,6 kali jumlah transistor,” ujar Huang dilansir dari The Guardian Selasa, (5/1/2025).

- Red Hat Luncurkan AI Enterprise, Platform Terpadu untuk Mengubah Eksperimen AI Menjadi Operasi Bisnis

- Guru Pesantren di Tasikmalaya Manfaatkan AI, Kelas Tahfiz Kini Lebih Terukur dan Fleksibel

- Hanya 19% Perusahaan Indonesia Siap Adopsi AI, Commsult Tawarkan Implementasi yang Lebih Praktis

- Cisco 360 Partner Program Percepat Transformasi AI Lewat Ekosistem Kemitraan

Vera Rubin tidak hadir sebagai satu chip tunggal, melainkan sebagai sebuah platform yang terdiri dari enam chip Nvidia terpisah.

Nvidia juga menyiapkan server unggulan yang akan memuat 72 unit GPU dan 36 prosesor CPU baru.

Huang menjelaskan, chip-chip tersebut dapat dirangkai dalam sistem besar yang disebut “pod”, dengan kapasitas lebih dari 1.000 chip Rubin.

Konfigurasi ini disebut mampu meningkatkan efisiensi pembuatan token AI atau unit dasar dalam pemrosesan kecerdasan buatan hingga 10 kali lipat.

Namun, peningkatan performa tersebut dicapai dengan penggunaan format data eksklusif milik Nvidia yang belum menjadi standar industri. Perusahaan asal Amerika Serikat itu berharap pendekatan ini dapat diadopsi secara lebih luas ke depan.

Meski masih mendominasi pasar pelatihan model AI, Nvidia kini menghadapi persaingan yang semakin ketat, baik dari pesaing lama seperti AMD, maupun dari pelanggan besar seperti Google (Alphabet) yang mengembangkan chip AI sendiri.

Karena itu, Nvidia menegaskan Vera Rubin dirancang untuk mempercepat inferensi AI, yakni proses menjalankan model AI ke ratusan juta pengguna chatbot dan aplikasi berbasis AI lainnya.

Salah satu teknologi baru yang diperkenalkan adalah “penyimpanan memori konteks”, yang bertujuan membantu chatbot memberikan respons lebih cepat, terutama dalam percakapan panjang.

Selain chip, Nvidia juga memperkenalkan generasi terbaru switch jaringan yang menggunakan teknologi co-packaged optics (CPO). Teknologi ini berperan penting dalam menghubungkan ribuan mesin dalam satu sistem AI berskala besar.

Nvidia menegaskan Vera Rubin akan melampaui performa chip lama seperti H200, yang sebelumnya diizinkan masuk ke China dan sangat diminati di pasar tersebut.