BRIN Kembangkan SKV-Cache, Teknologi Baru untuk Percepat Kinerja AI pada Arsip Pemerintah

BRIN kembangkan SKV-Cache untuk percepat inferensi AI hingga 2 kali lipat dalam sistem tanya jawab arsip pemerintah berbasis knowledge graph.

Peneliti BRIN memaparkan solusi SKV-Cache untuk pencarian arsip pemerintah. dok BRIN

Peneliti BRIN memaparkan solusi SKV-Cache untuk pencarian arsip pemerintah. dok BRIN

Badan Riset dan Inovasi Nasional (BRIN) mengembangkan semantic-aware key-value cache (SKV-Cache), sebuah framework baru yang dirancang untuk mempercepat sistem tanya jawab (question answering) pada arsip pemerintah berbasis knowledge graph (KG).

Peneliti Pusat Riset Sains Data dan Informasi (PRSDI) BRIN Nimas Ayu Untariyati menjelaskan riset ini berangkat dari persoalan tingginya latensi (waktu respons) yang dialami model bahas besar (LLM) saat melakukan penalaran kompleks di atas struktur pengetahuan berbasis graf.

Secara konteks, lanjut Nimas, aplikasi knowledge graph sangat penting untuk sistem kecerdasan buatan (AI) yang presisi di domain seperti hukum dan kearsipan.

“Pertanyaan kompleks seperti ‘Siapa yang mengesahkan peraturan tentang klasifikasi arsip dinamis?’ membutuhkan penelusuran beberapa langkah atau multi-hop dalam graf,” ujar Nimas dalam paparannya di International Conference on Computer, Control, Informatics, and Its Applications (IC3INA) 2025.

- Urai Limbah Plastik Jadi Bata Daur Ulang Lewat Tempat Sampah Inovatif

- Binus University Raih Rekor MURI Lewat 120 Inovasi Teknologi Mahasiswa di Techvolution 2025

- Teknologi Automatic Train Wash Plant (ATWP) Jadi Rahasia Gerbong Kereta Api Selalu Bersih

- Pertamina Lubricants dan ITS Luncurkan Dua Mobil Hemat Energi, Nogogeni X Evo dan Nogogeni VIII

Menurut Nimas, akar masalahnya terletak pada teknik caching standar (KV Cache) yang selama ini digunakan oleh LLM.

Metode tersebut dibuat untuk teks linear, bukan untuk struktur graf yang kompleks seperti pada sistem arsip atau hukum.

Akibatnya, proses komputasi tidak bisa menggunakan kembali hasil dari entitas yang saling terkait secara semantik, sehingga setiap langkah (hop) harus dihitung ulang dari awal.

Dampaknya, sistem menjadi lambat dan kurang efisien, terutama untuk pertanyaan yang membutuhkan penalaran bertingkat.

Melalui SKV-Cache, BRIN ingin menghadirkan mekanisme cache yang memahami konteks dan relasi semantik antar-entitas, sehingga proses inferensi dapat berjalan lebih cepat tanpa mengurangi akurasi jawaban.

“Tujuan utama pengembangan SKV-Cache adalah mempercepat proses inferensi LLM pada tugas question answering over knowledge graph (KGQA) yang kompleks, tanpa menurunkan akurasi,” jelas Nimas.

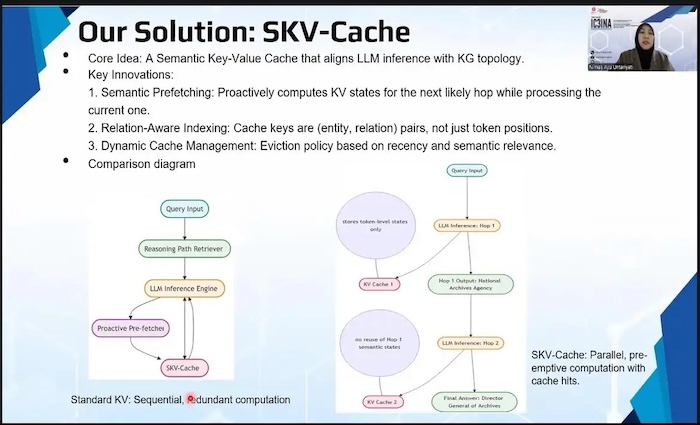

Riset ini mengusulkan tiga inovasi inti dalam arsitektur SKV-Cache yang terintegrasi langsung ke pipeline LLM, yaitu:

Semantic Prefetching – pengambilan data secara proaktif berdasarkan hubungan semantik;

Relation-Aware Indexing – pengindeksan berbasis relasi antar-node dalam graf;

Dynamic Cache Management – manajemen cache adaptif yang menyesuaikan konteks pertanyaan.

Ketiga pendekatan ini memungkinkan sistem mengenali struktur pengetahuan secara lebih efisien dibandingkan metode caching konvensional.

Hasil riset menunjukkan peningkatan performa signifikan. SKV-Cache mampu bekerja 2,14 kali lebih cepat dibanding KV Cache standar.

Pada kueri tiga langkah (3-hop) yang kompleks, waktu pemrosesan turun dari 1.200 milidetik menjadi hanya 560 milidetik.

“Yang terpenting, peningkatan kecepatan ini tidak mengurangi akurasi. Skor F1 dan BERTScore sistem kami tetap setara, bahkan sedikit lebih baik dibanding baseline,” tambah Nimas.

Penerapan SKV-Cache diharapkan dapat mendorong pengembangan AI interaktif dan real-time di bidang-bidang penting seperti hukum, kearsipan pemerintah, dan layanan publik lainnya.

Dengan kemampuan memahami hubungan antarpengetahuan, AI dapat merespons pertanyaan kompleks dengan cepat dan tepat.

Nimas menegaskan inovasi ini juga memiliki nilai metodologis yang besar.

“Pengembangan SKV-Cache dapat menjadi langkah awal pergeseran paradigma dalam desain optimasi LLM, dari yang hanya menganggap teks sebagai urutan linear, menjadi sistem yang memahami struktur pengetahuan yang kaya,” ujarnya.

Sebagai bagian dari semangat kolaboratif, BRIN juga berencana membuka kode SKV-Cache secara open-source agar komunitas riset dapat berkontribusi dalam penyempurnaan dan adaptasi framework ini ke berbagai domain lain.